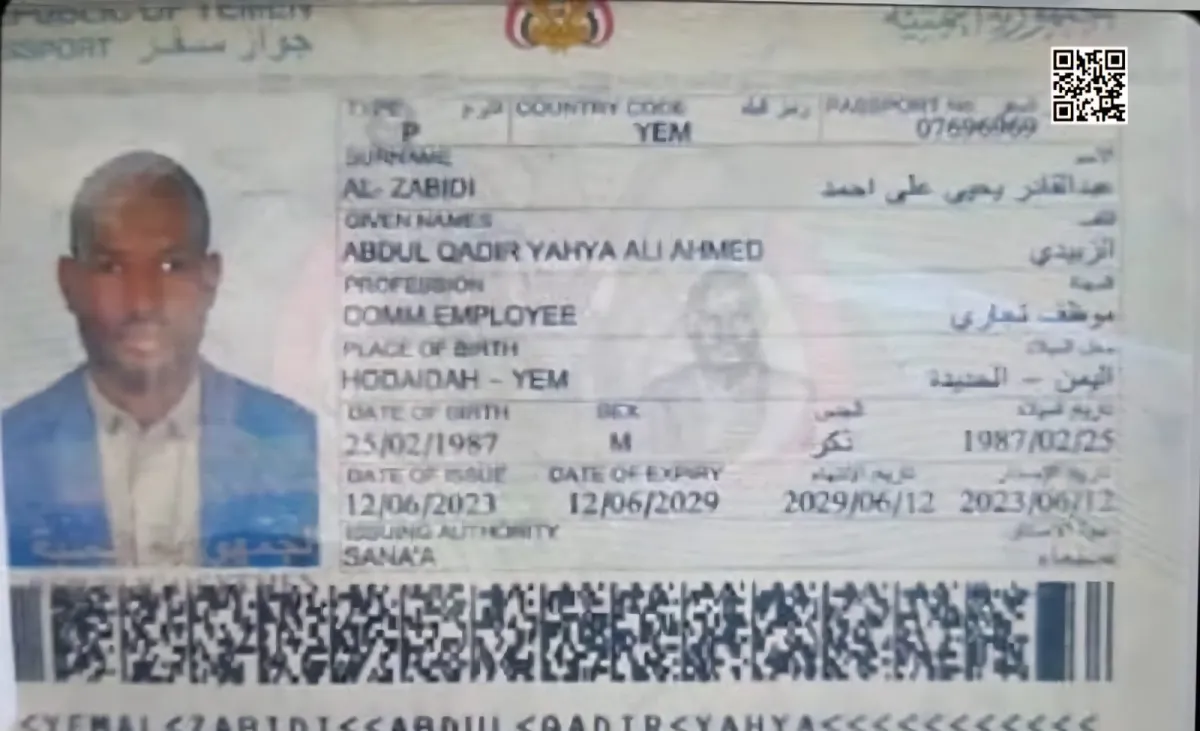

رئيس "Group-IB" يحذر من أن توظيف الذكاء الاصطناعي في الهجمات السيبرانية أزال "العنق الزجاجة البشري"، محولاً الجريمة الرقمية من مهارة فردية إلى صناعة قابلة للتوسع والإنتاج الضخم. يشير دميتري فولكوف، الرئيس التنفيذي لشركة أمن المعلومات "Group-IB"، إلى أن الموجة الحالية من الجريمة السيبرانية تمثل تحولاً جذرياً، حيث أصبح الذكاء الاصطناعي سلاحاً يُصنّع الجريمة. ففي الماضي، كانت سرعة نمو الجرائم مرتبطة بقدرة المجرمين على كتابة الأكواد أو التلاعب بالضحايا، أما اليوم، فيتولى الذكاء الاصطناعي هذه المهام فوراً وبشكل متكرر وعلى نطاق واسع. هذا التحول يعني أن المهام التي كانت تتطلب خبرة بشرية عالية، مثل صياغة رسائل التصيد المقنعة أو تطوير البرمجيات الخبيثة، أصبحت الآن مؤتمتة أو متاحة عبر أدوات ذكاء اصطناعي دائمة العمل. ويوضح فولكوف أن هذا مكّن حتى المجرمين الأقل خبرة من تنفيذ هجمات معقدة، مما أدى إلى تسارع هائل؛ إذ رصدت "Group-IB" ارتفاعاً بنسبة 371% في المنشورات المرتبطة بالذكاء الاصطناعي في منتديات الإنترنت المظلم بين عامي 2019 و2025. الخطورة تتجاوز مجرد الاستخدام؛ فالذكاء الاصطناعي يتحول إلى "بنية تحتية أساسية" للجريمة، خاصة في مجالات الاحتيال والهندسة الاجتماعية. الأدوات المتقدمة أصبحت تُباع بنماذج اشتراك منخفضة التكلفة، مشابهة لاشتراكات منصات البث، مما يلغي حواجز المهارة والمال أمام المهاجمين الجدد. هذا يجعل الجريمة أكثر مرونة واستدامة ويشبه طريقة عمل شركات البرمجيات السحابية المشروعة. من أخطر التطورات هي "قابلية برمجة الهوية"، حيث يمكن تصنيع وبيع الأصوات والوجوه والوثائق المزيفة. وقد وثقت الشركة 8065 محاولة تجاوز لأنظمة "اعرف عميلك" (KYC) باستخدام تقنيات التزييف العميق في الفترة بين يناير وأغسطس 2025 فقط، مما أدى لاكتشاف آلاف الحسابات الاحتيالية. يؤكد فولكوف أن رؤية شخص أو سماعه لم يعد دليلاً كافياً في عالم ما قبل التزييف العميق. ويشدد على أن التشريعات الحالية متأخرة وغير متسقة، مما يسمح للمجرمين باستغلال الفجوات العابرة للحدود. ويختتم بدعوة ملحة لوضع الذكاء الاصطناعي في صميم استراتيجيات الأمن وتعزيز التعاون الدولي لمواجهة هذا النظام الإجرامي المترابط. |